AI研究が進歩するにつれて、人間にどこまで近づけられるかという話題になっている。AIの研究者ではなく、一般人が持つ懸念点の一つととして、AIが感情を持てるか否かという点が挙げられ、コメントが寄せられている場面をネットやリアルでしばしば見かける。AIが感情を持つことを肯定的に考える人は、鉄腕アトムやドラえもんを引き合いに出し、人間に共感してくれるAIを想定し、否定的な人は、いわゆるターミネーター的世界観のように人間に対抗的なAIを引き合いに出すことが多い。

マーク・F.ベアーらの著書「カラー版 神経科学〜脳の探求」によれば感情(翻訳書ではemotionを「情動」と翻訳)は、愛情、憎悪、嫌悪、喜悦、羞恥心、羨望、罪悪感、恐怖、不安を指し、自律神経応答と交感神経応答を含む脳が、生命を維持するために本能的な危険、過去の不快な体験の記憶、快い体験の記憶を活性化させ身体的な反応を励起することによるものであると説明されている。それに従うと、AI自体はアルゴリズムであり生命体ではないので、これらの要素を本来的に持つことはなく、感情を持つ必要はないと考える。しかし、人間のためにAIを役立てようと考えた場合、相手の感情に応じた対応を取るように振る舞うために相手の感情を認識することは人間にとっても有益である。よって、AIは自己の感情を持つ必要はないが、相手の感情を認識する必要があると言える。

人間にとっても、相手の感情を的確に認識することは難しく、さらに、自分の感情の発生の因果関係を客観的に説明、表現することも難しい。だからこそ、客観的に感情を認識することは新たな可能性を有しており今後ビジネス的にも重要と考えられる。ここでは、AIがどのように感情を認識するかについて説明する。

感情認識の仕組みとは

感情とは、前にもの述べたように、生存本能に根ざすものである。生存本能に関係がある事象を経験した際にホルモン分泌によって脳内に伝播することがわかっている。ホルモンが分泌する仕組みは未解明であるが、脳は無意識に常に将来を予測しており、予測と異なる現実となり、その違いが生存本能に関係する内容であった場合、体内の各器官に反応させるためにホルモンを分泌させるという説もある。このように、人間は感情によって意識的、無意識的に身体が反応する。身体反応のほとんどは身体内の反応であるため第三者が相手の感情を認識することができるのは通常、言葉に代表されるバーバルの反応と顔の表情や発声音、口調のようなノンバーバルの反応からである。

人間が対面でコミュニケーションを行う場合、相手の感情を認識する根拠の9割がノンバーバルの情報とされている。一方、メールやネットの書き込みの様にバーバルをノンバーバルと切り離して表現する場合、正しく感情が伝わらない、もしくは強めに伝わるというように、本来伝えたい感情と異なる強さで伝わってしまう場合があると言われている。この様に、人間の感情認識にはノンバーバルの情報が重要ということがわかる。

近年のAIによる感情認識は人間と同様に感覚器によってノンバーバル情報を取得する方法が考えられている。ただし、感情は表現の仕方も、感じ取り方も極めて主観的であり、人それぞれによって異なっており、誤解を発生することが多いため、AIでも細かな機微を学習し、認識することは困難である。現段階でAIが認識できるのは心理学や統計的調査で判明している大まかで、平均的な感情変化にすぎない。入力情報によって以下のように感情認識方法が異なる。

・画像による感情認識

表情や顔面の血色の変化によって感情を認識

・音声による感情認識

声の大小、高低や周波数の変化によって感情を認識

・生体情報による感情認識

ヘルスケアアプリやデバイスによって計測される脈拍などの変化によって感情を認識

感情認識で何が変わるのか

「目は口ほどにものをいう」と言われるように、人間は無意識に感情が表情等に出る。これまでは、第三者が感情を認識するには本人が音声、文章、アンケートなどで自分の感情を意識的に表明するか、対面によりノンバーバルも含めた情報を取得し人間が判断していた。この場合、本人がうまく感情を表現できない、または、いわゆる「空気を読む」ことにより感情を表に出さないなどの原因により的確に感情を認識できないという状況が生じていた。また、感情を認識する人間側の経験、その時点の相対的な感情などのゆらぎにより判断が左右されていた。

AIによる感情認識で相手の感情が客観的に認識可能となることにより、リアルタイムで相手の感情に合わせた対応・応答が可能となりサービスレベルの向上が図られる。また、感情という曖昧な内容がデータ化されるため大衆の反応についてもより詳細に把握することが可能になる。例えば、テレビ番組の人気の指標である視聴率は、どのチャンネルが視聴されているかという事象を表すデータであったが、「視聴質」という、視聴者がきちんとテレビの前にいて見ていたか否かというデータに変わりつつある。将来的に視聴質が目指すものとしては、視聴者の表情を逐次認識をし、番組に対する感情を取得することであると言われている。視聴者の感情認識により、場面ごとの感情や番組平均的な感情を製作側が知ることで、その後の番組制作へのフィードバックが図られることが期待されている。

感情認識の活用事例~視聴者の感情を分析する

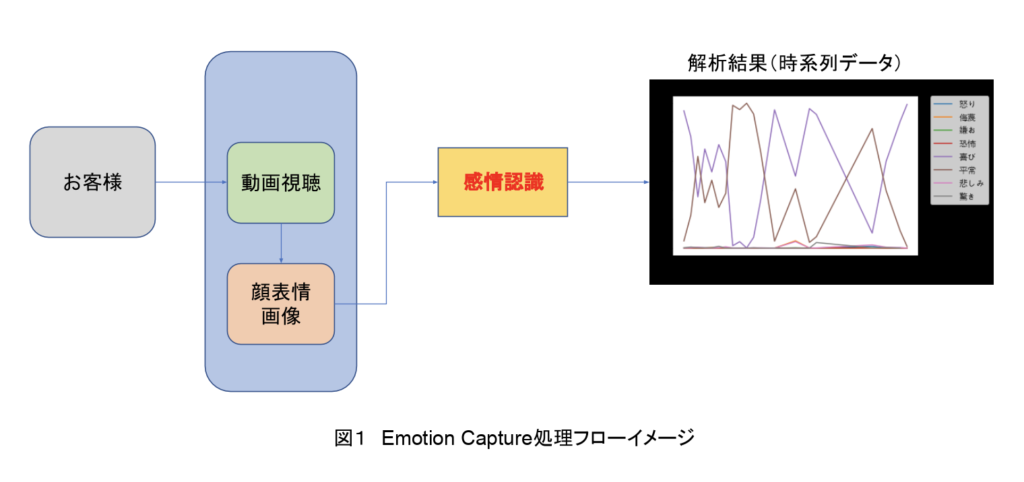

画像による感情認識の活用事例としては、凸版印刷がシステム開発のシーエーシー、米ベンチャーのアフェクティバと実用化を進めるAIソリューションが代表例として挙げられる。このAIでは、表情分析体系である「FACS(ファクス)」の専門家を使い、教師データを集め、学習している。「FACS(ファクス)」は、顔の筋肉を40以上のユニットに整理し、それぞれの動きの大きさで表情を定義し、感情と表情筋の連動性を詳細に解析する。このソリューションを活用して東急エージェンシーが動画評価Web調査サービス「Emotion Capture」を提供開始している。Emotion CaptureはスマートフォンやPCのwebカメラを利用して、動画視聴時の表情の動きを測定し、それを基に、その動画によって引き起こされた視聴者の感情をAIで分析する。

また、マイクロソフトもクラウドサービスAzure上で提供するコグニティブサービスの一つとして顔認識機能Face APIを提供している。Face APIは画像内の顔を識別するとともに表情から感情を識別する。

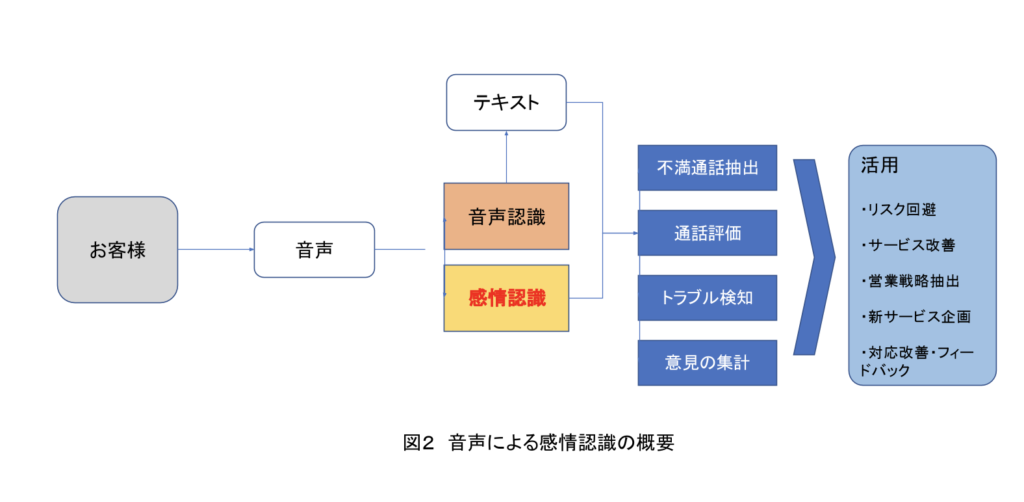

富士通はコールセンターの対応改善に利用するため、音声を活用し、教師データの取得が容易な声の高さと大きさのみで満足度を評価するAIを開発した。

また、Empathは、音声等の物理的な特徴量から喜怒哀楽や気分の浮き沈みを判定するWeb APIを開発し提供している。

まとめ

AIが相手である人間の感情を認識し、相手の感情に応じた対応を取るように振る舞うことは利用者である人間にとっても有益である。人間自体でも相手の感情を的確に認識することは難しく、さらに、自分の感情の発生の因果関係を客観的に説明し、制御することは非常に困難である。だからこそ、客観的に人間の感情を認識することは新たな可能性を有しており今後ビジネス的にも重要と考えられる。

<参考>

- カラー版 神経科学―脳の探求(マーク・F. ベアー (著), マイケル・A. パラディーソ (著))

- ヒトよりも「空気」を読める感情認識AI 本人より先に「眠気」に気づくことも可能に(日経ビジネス)

https://business.nikkeibp.co.jp/atcl/report/15/278209/012200182/ - 人の感情を認識するAI「Affdex」(Affectiva)

https://affectiva.jp/ - 感情認識AIを用いた動画評価Web調査サービス 「Emotion Capture」を開発、販売開始

http://www.tokyu-agc.co.jp/news/2018/release20180626.pdf - WEB Empath APIについて(Empath)

https://webempath.net/lp-jpn/

役にたったらいいね!

してください

NISSENデジタルハブは、法人向けにA.Iの活用事例やデータ分析活用事例などの情報を提供しております。