AI(人工知能)を医療現場に導入する動きが加速している。「加速」とはつまり、AIは一部の作業ですでに、医師や看護師などの医療スタッフより優れた実績をあげていて、その実績はこれからまだまだ増えていく、という意味だ。

医療のIT化が進んだように、医療のAI化の流れは止められそうにない。

こうした流れを受けて政府は2018年6月、AI医療機器に関するルールを整備する、とした。その方針のなかで最も重要なのは、AIを使った診療であろうと最終的な責任は医師が負う、という考え方だ。

「AIを使った医療でミスが生じたら医師が責任を負うのは当然」と考えるだろうか。しかしことはそう簡単ではない。

なぜならAIは、

・AI自身が考える

・考えたことを人に教えない

という性質があるからだ。

医師がAIの判断とおりの治療を行い、その結果患者の健康や命が損なわれても、医師はAIに「なぜそのような判断をしたのか」と問うことはできない。医師どころか、AIの開発者も「なぜAIがそう考えたのか」を説明できない。

「AIの医療ミスは医師の責任」とするだけで、本当に大丈夫なのだろうか。

AI医療の事例

東京のある神経内科医院では、初診の患者が来院しても問診票を渡さない。その代わりタブレットを渡す。

問診票とは、患者に症状を尋ねる質問用紙で、患者がそれに答えることで医師は病名を推測する。

この医院で使っているタブレットは、単に紙の問診票をペーパーレス化しただけではない。タブレットにはAIが搭載されている。

このAI問診タブレットは、患者の回答によって質問を変えていく。患者が1つの質問に回答すると疑われる病気を絞り込み、その病気に関連する質問をするのだ。医師が患者に質問するときと同じように、「この症状があるということはあの病気が疑われる」「この症状がないということはあの病気の可能性は消える」と考えるのだ。

このAI問診タブレットは、病気の知識を医学論文などで学習している。開発したのは、医師が共同代表を務めるユビー株式会社(本社・東京)という医療ベンチャーだ。

このAI問診タブレットには、2つのメリットがある。

1つ目は、医師のカルテ入力作業を減らしたことだ。タブレットは医師のカルテ用パソコンと連動していて、患者の回答がそのままカルテの下書きになる。紙の問診票だと、医師は問診票をみながらカルテに打ち込んでいかなければならなかった。

2つ目のメリットは、患者の負担が減ったことだ。患者はタブレットの画面をタップするだけなので、入力時間が3~4分で済む。紙の問診票では平均7分ほどかかっていた。

AI医療は、画像診断でも力を発揮している。

日立製作所と東京医科歯科大学は2018年4月に、潰瘍性大腸炎やリウマチなどの難病の治療で連携すると発表した。潰瘍性大腸炎もリウマチも、初期症状がそのほかの軽い病気と似ているので、地域のクリニックだと早期発見が遅れる可能性がある。そこでMRI(磁気共鳴画像装置)やCT(コンピュータ断層撮影装置)の画像をAIで解析する方法を両者で構築していく。

AIに、MRIやCTで撮影した画像のなかから病気の兆候を探す能力があることは、他の病気で証明されている。日立製作所と東京医科歯科大学は、そのAIの能力を難病の早期発見に応用しようというのである。

AI問診票もAI画像解析もすでに、特定の能力に限っていえば、正確さやスピーディーさで人の能力を超えている。

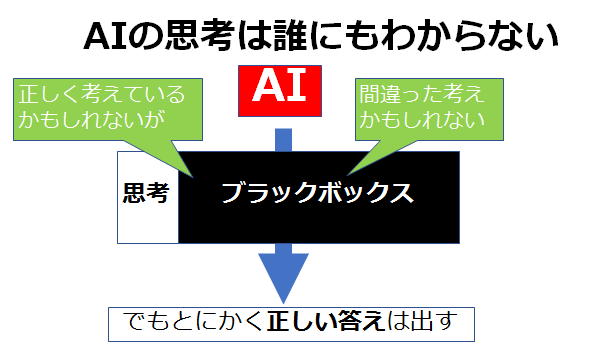

しかしAIにはブラックボックスという大きな欠点がある。

AIの思考は開発者ですらわからない

AIの賢さは、到底1人の人間では覚え込むことができない量の資料を簡単に覚え、そのなかから法則を探せることにある。

将棋AIが人のプロ棋士に勝てたのは、プロ棋士でも学べないほどの量の棋譜を読み込み、そしてプロ棋士でも思い浮かばなかった一手を思いついたからだ。

ただAIは、なぜその一手を思いついたのか、人に説明することはできない。

ちなみに、AIを搭載していない普通のコンピュータなら、「コンピュータがなぜその答えを出したのか」は簡単にわかる。なぜなら普通のコンピュータは、プログラマーがつくったプログラムとおりにしか動かないからだ。だからプログラマーは「コンピュータの思考」を説明できる。

しかしAIの場合、そのAIを開発した開発者ですら、「なぜAIがそのような答えを出したのか」がわからない。

例えばAI画像診断の場合、「なぜAIがその微小ながんを発見できたのか」は、医師にもAI画像診断の開発者にも説明できない。

なぜならAIが自分で「微小ながんを発見する法則」を考えついたからだ。そしてAIには、自分の考えを人に教える機能が備わっていない。

つまりAIの思考は、完全にブラックボックスのなかにある。だから可能性としては、AIは間違った理屈で正しい答えを出しているのかもしれないのだ。

AIメーカーの責任はなくていいのか

可能性の話を続ける。

AIが間違った理屈で正しい答えを出していたら、何が問題になるのだろうか。「正しい答えを出しているのだから、結果オーライとしていいのではないか」とも思える。

しかし間違った理屈で正しい答えを出している場合、こういったことが起きる可能性が残ってしまう。

・間違った理屈で9,999回正しい答えを出した後に、必ず10,000回目に間違った答えを出す

つまり10,000回に1回必ず医療ミスを起こすAIをつくってしまう可能性があるのだ。

しかし人は、AIの考え方がわからないからそれを検証できない。ということはAIがミスを犯しているのに、医療スタッフが疑われることになるかもしれない。なぜならAIは9,999回も正しい答えを出しているのだから。

このAIが1,000,000回の症例を診れば医療ミスが100回起きるので、そのときようやく人は、AIが「犯人」であると気がつくかもしれない。

このケースでも、医師が責任を問われてしまうのだろうか。そしてAI開発者の責任が問わなくていいものなのだろうか。

もちろん、医師もミスを犯す。そして医師のミスによって命を落とす事故も多数発生している。しかし医師のミスの場合、裁判などで「なぜそのようなミスを犯してしまったのか」問うことができる。そのミスが、最良の医師の細心の注意によっても避けられなかったとわかれば、被害者や遺族も納得できるかもしれない。もちろん、ミスを犯した医師の過失が大きければ、賠償金を求めることができる。

「AI医療には限界がある」とする医師は多い

AI医療の能力を疑う医師は、実は少なくない。医師で構成する組織としては国内最大級である公益社団法人日本医師会は2018年7月、「人工知能と医療」というタイトルの提言を公表した。

この提言では、「AIの限界は十分認識しておかなければならない」と明言している。さらに、「AIの悪用に懸念している」とも述べている。AIに懐疑的な姿勢が透けてみえる。

さらに「AIの利活用はデータの集積が最も重要である」とも述べていて、これはAIの利用に制限をかけようとしているようにも映る。

もちろんこの提言はAIを全否定しているわけではない。最後に「人とAIが協調する素晴らしい医療を望みたい」と結んでいる。しかしAIと医療の協調は、もう少し先の未来であると考えられている。

まとめーAI医療の慎重な導入は利益が大きいのかデメリットが大きいのかー

医療界は実は、さまざまな産業のなかでもとりわけIT化が遅れた分野である。日本の医療といえば最新テクノロジーのかたまりというイメージがあるので、意外な印象を受けるかもしれないが、いまだに手書きのカルテを使用している医療機関は少なくない。

少なからぬ医師がITを信用しなかったのは、人の命を預かる使命感からだろう。「新参者」で実績のない」ITに頼ったばかりに患者の健康や命を損なう結果になってはならないからだ。

同じことがいま、医療のAI化の流れのなかで起きている。AIは便利だから医療に使ってこそ人類に貢献できると考える人と、「新参者で実績のない」AIに自分の患者を任せたくない医師がいるのだ。

そうなるとやはり、「人とAIが協調する素晴らしい医療を望みたい」というしかないのかもしれない。

AIが爆発的に賢くなるシンギュラリティ(技術的特異点)が到来するまでは、AI医療の導入のメリットとデメリットを慎重に測りながら実用化していくしかないだろう。

<参考>

- 政府、AI医療に包括ルール 「医師に最終責任」規定へ(日本経済新聞)

https://www.nikkei.com/article/DGXMZO32207330V20C18A6MM8000/ - 世界中の人々を適切な医療に案内する(ユビー株式会社)

https://www.company.dr-ubie.com/ - 日立と東京医歯大 AIでリウマチ早期発見(日本経済新聞)

https://www.nikkei.com/article/DGXMZO29568420Z10C18A4X90000/?n_cid=SPTMG053 - 異色の東大卒「医師起業家」が医療を変える アントレドクター 第1部(上) (日本経済新聞)

https://www.nikkei.com/article/DGXMZO32088730R20C18A6X11000/?n_cid=SPTMG053 - あなたはAIを信用できますか? AIが出した結果の根拠を説明する技術(FUJITSU JOURNAL)

http://journal.jp.fujitsu.com/2018/01/23/02/ - 人工知能(AI)と医療 第3回人間中心のAI社会原則検討会議2018年7月5日(公益社団法人日本医師会 羽鳥裕)

http://www8.cao.go.jp/cstp/tyousakai/humanai/3kai/siryo2-1.pdf

役にたったらいいね!

してください

NISSENデジタルハブは、法人向けにA.Iの活用事例やデータ分析活用事例などの情報を提供しております。