先日の検索サイト大手であり、デジタルジャイアンツの一角であるGoogleによる「Google I/O 2018」の中で、AIに関する驚異的なデモが行われたのをご存じだろうか。音声アシスタントと言い、一種のチャットボットなのだが、スピーカーからは、すでにチャットボットの域を超えている完成度で、本当に人間同士で話をしているとしか思えないレベルの会話が流れてきたのだ。

今回はこれら、音声アシスタントの未来について紹介したい。

Google音声アシスタントでなにができるようになるのか

そもそもGoogleをはじめ、各社は音声とAIを組み合わせたサービスを展開している。日本で最初に有名になったのはAppleがiPhoneに搭載した「Siri」だろう。「Hey, Siri」というかけ声をきっかけとして音声で話しかけると、それに対し、音声で回答をするという音声アシスタントだ。

それ以降、Googleは「Google音声アシスタント」を、WindowsやOfficeで有名なMicrosoftは「Cortana」を、そして物流業界の巨人amazonも「Alexa」を投入してきた。

これらの音声アシスタントはスマートスピーカーとも連動し、「Google Home」や「amazon Echo」などがリビングや寝室に入ってきているご家庭もあるかも知れない。

驚異のクオリティを達成していたGoogle I/O 2018でのデモ

それでも、現在の音声アシスタントは、いかにも合成音声という感じの声やしゃべり方でしか話してくれない。「○○の場合は数字の1を…」という電話の自動対応音声案内と同じ様な感じと言えばわかるだろう。しかし、今年の「Google I/O 2018」で行われたデモは、そこから考えると驚異的なものだった。英語ではあるが、まさに人間が会話しているとしか思えないイントネーションでの音声がスピーカーから流れ出した。そして、電話をかけて美容院の予約を取ったのだ。

手順としては、電話先に「3月3日に予約したい」旨を伝えたあと、次のような会話がなされた。

「何時頃が良いですか?」

「12時頃」

「12時は難しいです。近い時間ですと1時15分です」

「10時から12時の間ではどうですか?」

「サービスの内容に依ります。どのようなサービスをご希望ですか?」

「散髪のみです」

「でしたら、10時なら大丈夫です」

「では10時でお願いします」

という感じのやりとりを約1分にわたって行った。しかも、まるで人間が話しているかのような自然な口調、イントネーションで行っていたのである。かなり進化したと感じるデモだった。

進化した音声アシスタントが描く未来の生活

では、もうこれができる、できてしまうという前提で、今後は音声アシスタントがどの様に発展していくのかを考えてみよう。

例えばamazon Echoを考えてみよう。これまではamazonの開発したAI「Alexa」を搭載したamazon Echoに話しかければ、それだけでamazonで買い物ができてしまうというのは知っている方も多いだろう。しかしGoogleの新しい音声アシスタントはそれだけでは収まらない。

今回の美容院の予約ではないが、同じ様な例で言えばレストランの予約もできるだろう。音声アシスタントにカレンダーやスケジューラーへのアクセス許可を与えておくと、なお良い。この状態で

「良い雰囲気のイタリアンのレストランの予約を取ってくれ」

と指示を出せば、勝手にネット上で「良い雰囲気のイタリアンレストラン」の候補を洗い出し、ネットでの予約が可能であれば予約を行う。もし予約には電話が必要であれば、Webサイトで電話番号を見つけて勝手に電話をかけ、レストランの空きと自分の予定の空きを確認して、予約を行い、自分のカレンダーに予約した日時が登録される。こういうことを自動で行ってくれる。自分でレストランを探したり、予約の電話を行う必要は無い。

ビジネスの世界にも自動化の波

一方、これをレストラン側で考えるとどうだろう。Googleアシスタントと予約の受付システムが繋がっていれば、電話がかかってきた際に、自動で相手の希望日時を聞き出し、そこが予約可能かどうかを判断し、空いていればそのまま登録。空いていなければ、予約可能な日時を案内し、かけてきた相手に再考を促すという事が自動でできるようになる。予約受付の自動化だ。

これは、小規模店舗や個人経営の店舗で有効である。なぜなら、少人数で運用している店舗は、電話が鳴っても対応できない場合が多いからだ。従って、この仕組みがあれば、来客対応で電話に出られない場合でも自動で対応がなされ、電話に出られないために逃げてしまったかもしれない客をきっちりと取り込める事になる。あくまでも店にいる客に集中しながらも、予約を逃がさないという、人手不足のこの折りには大変役に立つシステムになる。

Google音声アシスタントの仕組み

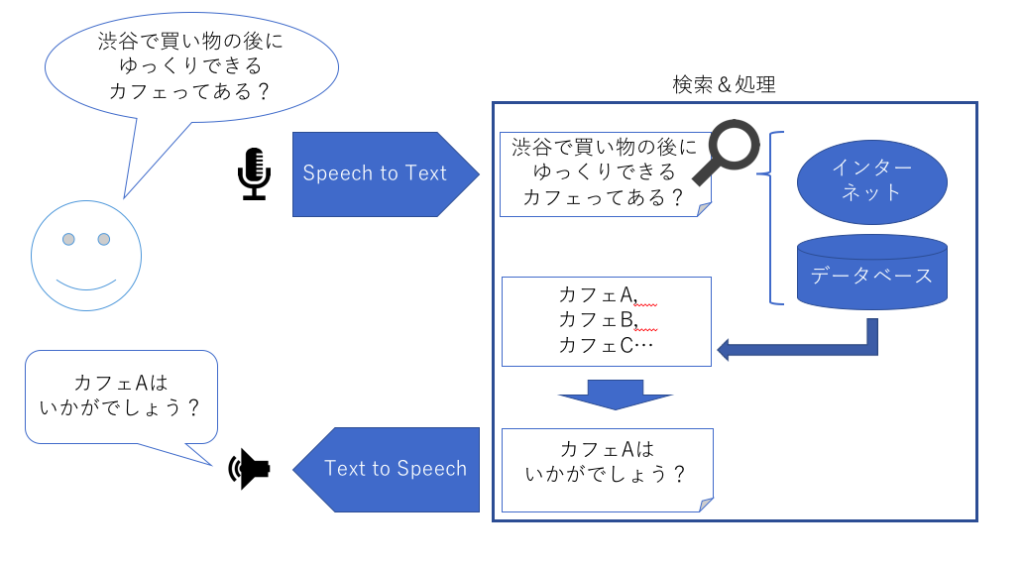

では、この音声アシスタントはどの様な仕組みで動いているのだろうか。ここではGoogleアシスタントを例に、その仕組みを解説する。

音声アシスタントは、基本的にインターネットを介して問い合わされた内容に対する回答を返している。その際に使われるデータはテキストデータである。テキストデータであれば、それを使っての検索が可能となるからだ。

まずはテキスト化

しかし、音声アシスタントについては、音声で話しかけるわけであるから、まずは音声データをテキスト化する必要がある。これは音声認識の機能であり、「Speech to Text」と呼ばれる。このテキスト化の精度が、その後の検索結果向上に繋がるため、ここは高い精度が要求される。以前は

「ゆっくり、はっきり、わかりやすく喋る」

や

「発音のクセを事前に登録する」

などの補助手段を利用して精度を上げていたが、現在では高精度を担保するためにAIも活用されている。同じ文章を多くの人間に読み上げてもらい、学習させることにより、発音の揺れやイントネーションの違いなどがあっても、それらが同じ内容であると判断させるのだ。これによって、どのような発音やイントネーションで音声がやって来たとしても、精度良くテキスト化されるように工夫している。

テキストによる検索

この音声認識によってテキスト化された音声データを、インターネットや、データベースの検索キーワードとして利用する。この部分は既存の検索作業と同じである。これまではキーボード入力などで行っていた作業を、音声入力で行ったわけだ。ただし、音声入力の場合、利用者はどの様に問い合わせるかが一言一句わかっているわけではない。従って、どういう意味の事を問い合わせているのか、を認識する事が重要になる。

ここは自然言語処理を得意とするAIの出番となる。基本的にはチャットボットのしかけと同じだが、問い合わせ内容を振り分けるなどすれば、返答として出すべき内容が決まってくる。決められた質問内容に答えるくらいであれば、既存のチャットボットと組み合わせさえすれば、音声によるガイダンスシステムができ上がる。既存の「○○の場合は1を…」というアナウンスは不要になる。電話をかけた人は、自分の問い合わせたい内容を電話に向かって喋るだけで良い。

音声合成による出力

検索した結果としての内容は当然テキストデータとして返ってくる。しかし、音声アシスタントでは音声データとして出力する必要がある。つまり、テキストデータを今度は音声に変換するわけだ。この音声合成技術を「Text to Speech」と呼ぶ。Googleの音声合成技術はかなり高く、比較的人間が読み上げているかのように聞こえる。もちろん良く聞けば他社のサービス同様、まだまだ合成音声であるというのはわかってしまうのだが、少なくとも「Google I/O 2018」のデモで使われていた英語のやりとりは、かなり自然に聞こえた。また、音声の種類も6種類から選べるようになっていた。今後、この部分はユーザビリティを考えると、大きく進化してくるだろう。

また、NTTコミュニケーション科学基礎研究所では、これまで蓄積したNTTの音声通話や発音に関する技術研究をベースに、イントネーションの自動調整プログラムを開発している。これは喉の振動を発音にフィードバックする方法で、例えば日本人の話すカタカナ英語を、ネイティブの人物が喋ったかのようなイントネーションや発音に自動修正してくれる。その逆もできる。まだ実験段階ではあるが、デモを見た感じでは、良くできていると感じた。ちなみに、訛りも再現できるようだ。これを音声合成技術と融合させると、テキストを用意するだけで、人間が話しているかのような日本語がスピーカーから流れてくる事になるはずだ。

まとめ

今回はGoogle音声アシスタントを中心に、音声アシスタントの仕組みと、その使い方について紹介した。

音声アシスタントは、マイクから入力された音声をAIなどを使ってテキスト化し、その内容でデータベース(インターネットを含む)を検索し、結果を合成音声でスピーカーから出力する。

これにより、人間はこれまでキーボードから入力していて行っていた検索を、マイクに向かって喋る事で行えるようになる。しかも、指示を出しておけば、先方とのやりとりは、相手がコンピューターであれ、電話先の人間であれ、音声アシスタントが自動で行ってくれ、その結果をスピーカーから報告すると同時に、自分のオンラインカレンダーやスケジューラーに登録してくれる。

そしてこれをどの様に活用するかは、読んでいる貴方次第だ。

<参考>

- Google Duplex: An AI System for Accomplishing Real-World Tasks Over the Phone(Google AI Blog)

https://ai.googleblog.com/2018/05/duplex-ai-system-for-natural-conversation.html - 「Googleアシスタント」の6種類の声や会話モードなどの新機能 予約電話代行も(ITmedia NEWS)

http://www.itmedia.co.jp/news/articles/1805/09/news075.html - 電話で人間そっくりに会話するグーグルの人工知能に、「AIのある未来」の一端を見た(WIRED)

https://wired.jp/2018/05/13/google-duplex-phone-calls-ai-future/ - Googleアシスタント(Wikipedia)

https://ja.wikipedia.org/wiki/Google%E3%82%A2%E3%82%B7%E3%82%B9%E3%82%BF%E3%83%B3%E3%83%88 - 主要スマートスピーカー/AIアシスタントを比較してみた(WirelessWireNews)

https://wirelesswire.jp/2018/01/63404/ - 英語の発音をネイティブのように綺麗に変換(NTT Communication Science Laboratories)

http://www.kecl.ntt.co.jp/openhouse/2017/exhibition/17/poster17.pdf

役にたったらいいね!

してください

NISSENデジタルハブは、法人向けにA.Iの活用事例やデータ分析活用事例などの情報を提供しております。