AI(人工知能)の技術のなかで、音声認識技術は重要な位置を占める。人が発した音声だけでコンピュータが動けば、作業効率が格段に上がるからだ。例えば音声を発しただけでコンピュータが文字に置き換えてくれれば、キーボードで入力する必要がない。

ところがコンピュータは、コンピュータ言語しか理解しない。そのため、音声をコンピュータ言語に変換しなければならないのだが、音声は文字よりも表現形態が複雑であやふやなため言語への変換は困難を究める。

そこで世界のAI企業は、コンピュータが人の音声を認識するAI音声認識技術の開発にしのぎを削っているのである。

では日本のAI技術はどこまで進んでいるのだろうか。AI音声認識技術の日本国内における導入事例を紹介する。

医師が喋っただけでカルテに記入できるシステム

株式会社アドバンスト・メディアは、医療法人と共同で医療向けAI音声認識ワークシェアリングサービス「アミボイス・アイノート」を開発した。

ワークシェアリングとは1つの仕事を複数人で受け持つことで業務を効率化させる仕組みである。アミボイス・アイノートを使えば、医師の仕事のうち医師でなくてもできるものを他のスタッフが担当することで、医師の負担を軽減させることができる。

アミボイス・アイノートを構築する基本的な要素は、スマホとパソコンと音声認識サーバーと電子カルテだ。医師、看護師、管理部門の担当者たちがスマホやパソコンを使って患者情報や治療の進捗状況などを入力すると、音声認識サーバーを経由して電子カルテのなかに記載されていく。

音声認識サーバーを使うのは、入力方法をキーボード入力だけでなく、音声入力でも行えるようにするためである。

アミボイス・アイノートでは、医師たちがスマホに話すだけで、話した内容が電子カルテに記録される。

電子カルテの記載内容は治療方針を立てるときなどに使われる重要なものだから、誤記は許されない。そこでアドバンスト・メディアは、医療用語に特化したAI音声認識エンジンを開発し、音声から文章に変換するときに誤記誤用が極力出ないようにした。

アミボイス・アイノートは既に提携先の病院で導入実証を行っていて、従来のキーボード入力より業務量が70%削減したという。導入実証に参加した41人の業務を足し合わせると、合計1日11時間分の業務を削減できた。

また参加者からは「音声入力は簡単で入力速度が速くなった」との回答が得られた。

音声認識AIはすでに実用レベルに達している。

音声に含まれる感情を解析するAI

株式会社エンパスが開発したのは、音声感情解析AI「エンパス」だ。

人の感情が言葉にのることは誰もが知っている。上司が部下に仕事を命令をして、部下が「わかりました」と答えたとき、上司はその語調や強さなどから部下が喜んでその仕事をするのか、嫌々その仕事をするのかがわかる。

エンパスも、この上司と同じように音声感情を見抜く。エンパスが確認するのは、音声の速さ、ピッチ、トーンなどで、これらを音声の物理的特徴量という。

エンパスは音声の物理的特徴量から、話者の感情を「喜び」「平常」「怒り」「悲しみ」の4つに分類する。また音声から「元気度」も割り出す。

エンパスはすでに商品化されていて、40カ国500社が利用している。またルクセンブルクやシンガポールの技術コンテストで優勝するなど、ITの専門家たちからも高く評価されている。

エンパスを会社の労務管理に使えば、社員の「隠れストレス」を発見することができ、メンタルヘルスの改善につなげることができる。

また顧客の音声感情を解析すれば「本音の満足度」がわかり、マーケティングの精度が上がる。

音声感情解析AIは、ビジネス環境を改善する即戦力になりうるのである。

コールセンター業務の質を向上させる音声認識AI

コールセンターを運営しているトランスコスモス社は、音声認識AIを使って、顧客やオペレーターの声をテキスト化(文章化)している。

管理職が音声から起こしたテキストをチェックすれば、オペレーターがマニュアルとおりに挨拶をしているかどうか、顧客の話に自分の話を被せていないかどうかなどがわかる。

このシステムは音声のテキスト化だけでなく、問題があると思われる箇所を抽出することができる。この抽出作業もAIが行っている。そのため管理職は、テキストをすべて読む必要がない。

問題のある言い回しが可視化できているので、管理職はオペレーターに具体的に改善を指示できる。

音声認識AIを使う前は、管理職はコールセンターの何十人ものオペレーターのやりとりを「ライブで」チェックしなければならなかった。音声は録音しないと確認できないからだ。

もちろんオペレーターと顧客の音声を録音することは簡単だが、例えば20人のオペレーターが毎日8時間働いていたら、管理職は毎日160時間分の音声を聞かなければならない。

そのためオペレーターの育成は、事前研修やOJTなどによるしかなかった。そして「独り立ち」すれば、管理職の監視が行き届かなくなる。

音声をAIでテキスト化することで、こうした課題を解決できたわけである。

三菱電機は声を拾う技術を確立

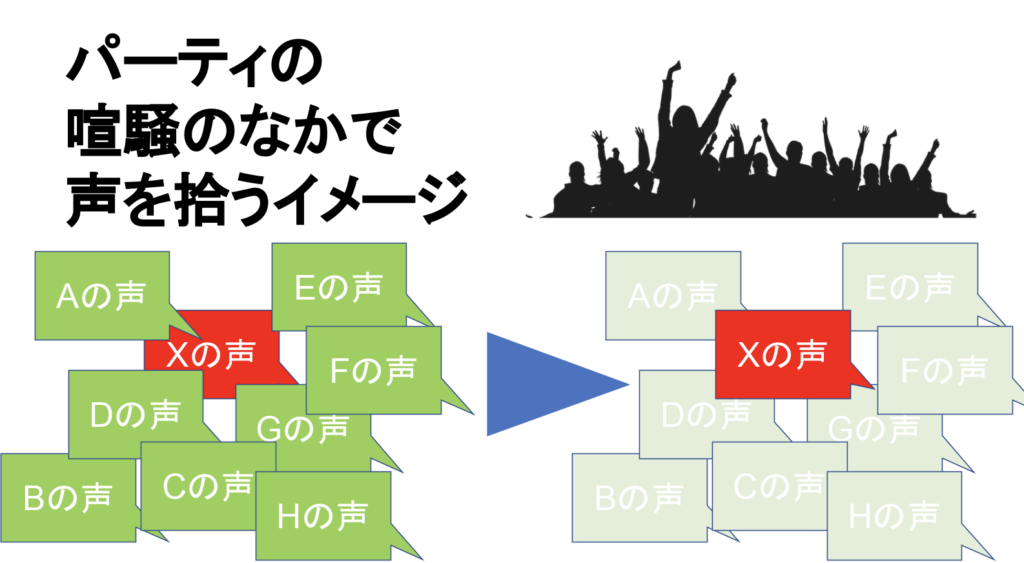

三菱電機はパーティの喧騒のなかで特定の人の音声だけを認識する技術を開発した。

三菱電機はAIに2人の声を重ねた音声を2万サンプル分聞かせた。するとAIは次第に、サンプルのなかに必ず音質が異なる音声が2つあることに気がつき始める。そして技術者がAIに2つの音声の分離の仕方を学ばせると、3人以上の声が重なっていても、それぞれ「なんといっているのか」がわかるようになった。

ただ、同時に話している人の音声を正しく文章におこせるのは、「2018年現在はまだ」2人同時までだという。

NTTは蛇口の水の音を無視するAIを開発

NTTはAIに蛇口から水が流れる音やテレビの音など、生活にあふれる音を1万5,000時間分聞かせた。AIにこれらの生活音を無視するよう教えるためだ。

NTTが一般家庭の普通の生活を再現した実験室のなかで人に話をさせ、その人から3メートル離した場所でその人の音声を拾った。その拾った音声をAIに聴かせたところ、人の話す言葉を90%の精度で文章化できた。

AIが生活音を無視したのである。

こうした技術はAI音声認識の精度を高めることにつながる。

2種類のAIを組み合わせてハイレベルの音声認識を実現する

2018年8月の日本経済新聞に「音声認識、AIで実力向上 文字変換や機器操作に」という記事が掲載された(*)。

*:https://www.nikkei.com/article/DGXMZO34278110X10C18A8MY1000/

常に最新トレンドを追いかけている日本経済新聞が紹介するAI音声認識技術は、そのときの最新技術と考えてよい。つまりこの記事に記載されている内容が、2018年夏の時点での日本の「AI音声認識技術の最新版」とみなすことができる。

この記事で注目したいのは、最新のAI音声認識技術は2種類のAIを組み合わせてつくっている、という内容だ。

音声認識技術を高めた2つのAIのうち1つめは、音声をミリ秒単位に区切ったり、ある音の前後の音を認識したりして、音声に含まれている情報を集める。

例えば人間の耳には「きつね」の「つ」も、「いつも」の「つ」も、同じ「つ」だ。

しかしこのAIは「きつねのつ」を「動物を表現するときのつ」と認識し、「いつものつ」を「状態を表現するときのつ」と認識する。

2つめのAIは、音声に含まれる日本語の文法と語彙を理解する。

従来のAIでも、発話者が「きつねがこんこんないていた」としっかり発音すれば「キツネがコンコン鳴いていた」と理解する。しかし従来のAIは、発話者が「つ」をはっきり発音せず「き■ねがこんこんないていた」(■は無音)と発音したら、もう「杵(きね)がこんこんないていた」などと理解してしまう。従来のAIは無音になった「つ」を想像できないのだ。

しかし日本語の文法と語彙を理解したAIなら「き■ねがこんこんないていた」と聞かされても、「コンコンと鳴くのはキツネではないか。『き』と『ね』は存在するので無音の『■』には『つ』が入るに違いない」と推測し「キツネがコンコンと鳴いていた」と理解するのである。

この2つのAIを使った音声認識技術は、人の話し言葉と読み言葉と電話での会話を聞き分けられるようになった。

まとめ~なぜ音声認識がそれほど重要なのか

音声認識技術はAI開発のカギを握る。音声は、文字や絵よりも格段にスピーディにコンピュータに指示を出せるからだ。

文字と絵でコンピュータに指示を出すことは手間がかかる。文字と絵は「かく」行為が必要だからだ。かくもの(例えば鉛筆やパソコンのキーボードなど)と、かかれるもの(例えば紙やディスプレイなど)も必要になる。

しかし音声は、人の喉と口腔だけで表現することができる。だから緊急時の指示は、文字と絵を使わずに、音声を使う。情報の発信者も、情報の受け手も手間がかからないからだ。

AI音声認識技術とは、情報伝達のスピード性に優れた音声を使って人とコンピュータのコミュニケーションを深めようとする取り組み、ともいえる。

<参考>

- 医療向け AI音声認識ワークシェアリングサービス「AmiVoice iNote」10月4日販売開始(PR TIMES)

https://prtimes.jp/main/html/rd/p/000000104.000020223.html - コールセンター向け音声認識AIの導入事例【トランスコスモス社インタビュー記事】(Big Data Magazine)

http://bdm.change-jp.com/?p=5049#i-2 - 音声認識、AIで実力向上 文字変換や機器操作に(日本経済新聞)

https://www.nikkei.com/article/DGXMZO34278110X10C18A8MY1000/ - 電子カルテの導入評価は賛否両論、その理由とは?(TechTargetJapan)

http://techtarget.itmedia.co.jp/tt/news/1303/06/news04.html - 医療情報システム(オーダエントリ・電子カルテシステム)導入調査(JAHIS)

https://www.jahis.jp/action/id=57?contents_type=23

役にたったらいいね!

してください

NISSENデジタルハブは、法人向けにA.Iの活用事例やデータ分析活用事例などの情報を提供しております。