無人化した兵器は、自国の兵士を傷つけずに敵国を叩くことができることから、各国の軍が長年研究している。しかしこれまでの無人兵器はリモートコントロールがベースになっているので、誰かが現地の様子をみながら操作する必要がある。そのため、確かに兵士は遠隔から無人兵器を操作することはできるが、完全に戦地から離れることはできない。

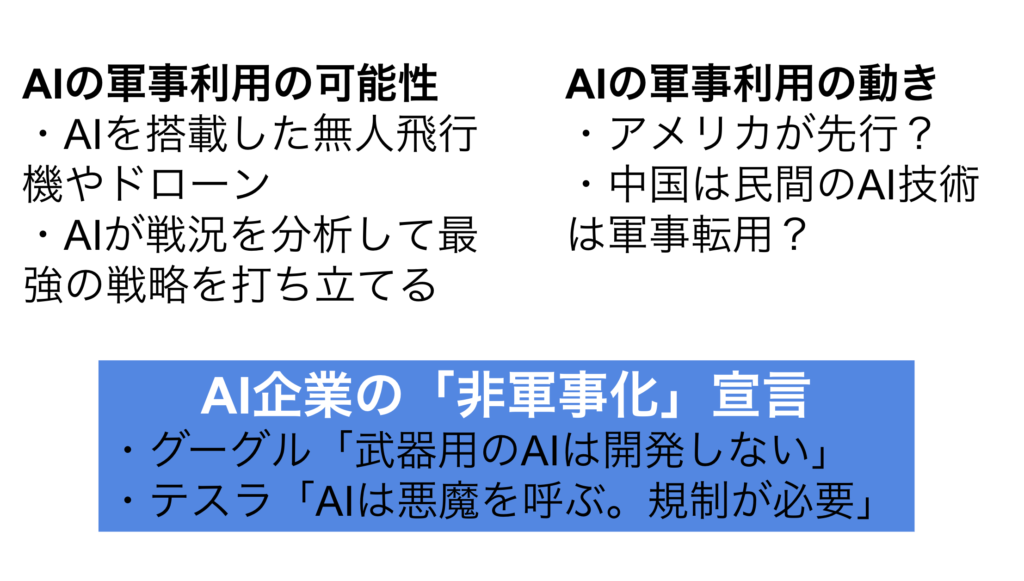

では無人兵器にAI(人工知能)を搭載したらどうなるか。「スイッチを押せば、あとは勝手に敵を倒してくれる」恐ろしい兵器になるだろう。そこでAI大国であり軍事大国であるアメリカと中国の両国は、AI兵器の開発を進めている。

嫌な話題だが、そもそもAIはその誕生当初から軍や兵器と深い関係にあった。戦争が科学を進歩させたことは悲しい事実ではあるが、AIもそのひとつということである。

しかしいま、AIのトップランナー企業が「兵器用のAIは開発しない」と宣言するなど、AIの反軍事化の流れも生まれつつある。

AIは誕生したころから軍に関係していた

AIの究極の姿は、コンピュータが人間のように思考することである。例えば囲碁のトッププロを倒したAI「アルファーゴ」は、囲碁のルールと戦術を理解し、対戦相手の何十手先も読むことができる。これは十分AIが「囲碁について思考した」といえそうだが、しかしアルファーゴは将棋では思考できないし、顔認証すらできない。つまりアルファーゴが人並みの思考をしたとは言い難い。

では「コンピュータが人間のように思考する」とはどのように定義されるのだろうか。

コンピュータが人間のように思考する、とは

イギリスの数学者で論理学者でコンピュータ科学者のアラン・チューリング(1912~1954年)は、現代のAI研究者が目指す「人間のように思考すること」を定義づけた人物である。人間の質問者が、ブラックボックスに入った人間またはコンピュータと会話をして、コンピュータと会話したときに「人間と会話した」と間違ったら、そのコンピュータは「思考した」といえる、とした。

これはチューリングテストと呼ばれ、その後、世界中のコンピュータ研究者がこれを目指すことになる。

チューリングのもう1つの顔

チューリングにはもうひとつの顔があった。それは暗号解読者という顔である。

チューリングは第二次世界大戦中、イギリス軍の暗号解読センターに所属し、敵であるナチス・ドイツ軍の暗号解読の任務に取りかかった。ナチスが構築した暗号「エニグマ」は当時、絶対に解けないとされていた。アメリカやイギリスなどの連合国軍は解読に躍起になったがまったく歯が立たなかった。

チューリングは独自にコンピュータを開発し、解読に成功したのである。エニグマが筒抜けになったことで連合国軍はナチス軍の攻撃を予測できるようになり、戦局は瞬く間に連合国軍側に有利な情勢に変わった。チューリングもあの戦争の終結を早めた1人に数えられている。

そしてチューリングはいま、コンピュータの父とも呼ばれている。チューリングの暗号解読技術がその後のコンピュータ開発に役立ったからである。その功績からすると当然の評価であるが、ただ彼の開発のモチベーションが「戦争に勝つこと」であったことは明白である。

つまりAIは生まれながらにして軍や兵器と深いつながりがあったわけである。

AIをどのように武器にするのか

「米中戦争 そのとき日本は」(講談社現代新書)の著者で、ハーバード大学アジアセンター・シニアフェローの肩書を持ち、さらに元陸上自衛隊東部方面総監だった渡部悦和氏は「中国はAI軍事革命を達成しようとしている」と警鐘を鳴らしている。

渡部氏によると、中国はAIを最重要技術と考え、2030年までにAIで世界をリードするという目標を持っているという。そして民間のAI技術を軍事転用するだろう、とみているのである。

無人兵器の威力が確実に増強される

AIを無人兵器に搭載するとどのような攻撃ができるのだろうか。無人兵器としてはすでに、ロボット、無人飛行機、無人船、ドローンなどが開発されている。

民間でAI開発が最も進んでいる分野は自動運転車である。完全自動運転が成功すれば、同じ技術を無人飛行機や無人船、無人潜水艦に搭載でき、正確に殺戮できるようになる。

またAIは顔認証や画像認証が得意である。ということは、攻撃対象の判別も容易になるはずである。つまり敵兵を確実に殺戮できるようになるのである。

アメリカが先行し中国がそれを追う

もちろん、最新兵器づくりでは、中国よりアメリカのほうが「先輩」である。

アメリカのIT兵器はこれまで世界をリードしてきた。レーダーに映らないステルス機能や精密誘導兵器、指揮統制システムなどがそれに該当する。

中国はアメリカを追いかけ追い越そうとしているのである。

かつての戦争は火力がものをいったが、現代の戦争は情報化戦争(informatized warfare)と呼ばれている。情報を獲得したほうが有利になる、という戦い方である。

そして近未来の戦争は知能化戦争(intelligentized warfare)になると予測されている。

戦争のAI化は兵器開発だけに限らず、戦略や戦術にも及ぶとされている。戦地の情報収集や集めた情報の分析はAIの力が発揮される。しかもAIなら過去の全世界の戦争の情報を学習することもできる。そうなれば「最強の作戦」を導き出すこともできるかもしれない。

グーグルは「武器用のAIは開発しない」と宣言

暗澹たる気持ちにさせる話を紹介したが、最後に希望が持てるニュースを紹介する。

グーグルは2018年6月にAIの開発と適用に関する指針を発表し、武器の開発をしないことを明確に示した。グーグルのこの平和思想は、社員たちからわき起こったものだ。

CEOピチャイ氏がなぜわざわざ公言したのか

グーグルのCEOスンダー・ピチャイ氏は自身のブログで、「AIを、人を傷つける分野に適用しない」と宣言した。さらに「武器用のAIは開発しない」とも記載した。

この宣言は素晴らしいものだが、しかしIT企業のトップがなぜわざわざ「AI兵器を開発しない」と公言しなければならなかったのだろうか。

実はグーグルはいま、アメリカ国防総省と一緒に軍事用ドローンを開発している。そのドローには攻撃対象を認識できるAIを搭載する予定で、グーグルの技術が生かされることになる。ところがグーグル社員約4,000人がこのAIドローン事業などに対し、反対署名で抗議したのである。それを理由に退職した社員もいた。

そこでグーグルは、国防総省との契約を2019年で打ち切ることを決めた。

つまりピチャイ氏はAIの平和利用を明確に示すことで、優秀な人材をつなぎとめようとしたのである。

AIは日常生活でも人を傷つけうる

ピチャイ氏は、先ほど紹介したブログ記事でAI開発の7つの指針を示している。

そこには「人を傷つける分野に適用しない」以外にも「不当な偏見を生み出すことを避ける」「安全のために使う」「プライバシー保護の原則を組み込む」ことが含まれていた。

つまりAIは、

・人を傷つける可能性がある

・不当な偏見を生み出す可能性がある

・危険になる可能性がある

・プライバシーを侵害する可能性がある

と読み取ることができる。

実際AIを駆使すれば、為政者の意のままに社会監視を強化することができる。AIには人を識別できる機能があるので、特定の人種の人たちだけ検知して除外することができる。

またAIを使えば、ある人の死亡リスクや発病リスクがたちどころにわかるようになるかもしれない。その機能を生命保険やがん保険のビジネスで使えば、ハイリスク者は保険に加入できないようになる。発病リスクが高い人を雇わない企業も出てくるだろう。

このようにAIは、戦場でなくても、日常生活であっても人を傷つけることができてしまうのである。

まとめ~AIを開発する者の責任とは

グーグルのピチャイCEOは、AI開発をリードする企業のトップとして「社会への影響について深い責任を感じている」と述べている。軍事利用や日常生活での脅威を考えると、当然のことだろう。

また、電気自動車(EV)大手で自動運転車開発も手掛けている米テスラのCEO、イーロン・マスク氏は、AIのことを「悪魔を呼ぶ技術」と述べている。そのうえで、AIの開発や利用には規制が必要であると提唱している。

しかしAIが「大いなる可能性」を秘めている以上、規制は簡単ではないだろう。というのもAIの非軍事化を宣言したピチャイ氏ですら、サイバーセキュリティ、訓練、捜索、救助の分野では軍に協力すると述べているからだ。

<参考>

- 中国人民解放軍が進める「AI軍事革命」は北のミサイルより恐ろしい(講談社)

http://gendai.ismedia.jp/articles/-/53869 - 「軍事用AIにNO グーグル指針、社員の声が後押し(日本経済新聞)

https://www.nikkei.com/article/DGXMZO31530230Y8A600C1000000/?n_cid=NMAIL007 - グーグル、AIの兵器利用を禁止 CEOが原則発表(AFP)

http://www.afpbb.com/articles/-/3177687

役にたったらいいね!

してください

NISSENデジタルハブは、法人向けにA.Iの活用事例やデータ分析活用事例などの情報を提供しております。