音声認識や言語認識などを駆使したAIアシスタントのように、人間とコミュニケーション可能なツールが続々と誕生している。とはいえ、コミュニケーションは言語処理や音声処理だけでは尽くされず、感情を表現したり補助的な道具でコミュニケーションを補助したりするなど、人間のコミュニケーション能力にはまだまだ及ばない。

では、AIによってどこまでコミュニケーション能力が向上させられるのだろうか。事例を添えつつ、紹介していこう。

続きを読む人に近づきづつある人工知能のコミュニケーション能力

長い歴史のある自然言語処理研究

AIのなかでも性能の高さで知られるディープラーニング。画像認識や音声認識など、パターン認識に強みを発揮するAIでもある。ディープラーニングの基礎にあるのが、「ニューラルネットワーク」と呼ばれる人間の脳を模した数理モデルだ。ディープラーニングが登場する以前からニューラルネットワークで自然言語処理の研究が行なわれていた。

言語処理でもディープラーニングは実力を発揮し、AIアシスタントやチャットボットにも応用されている。AIアシスタントとは人間の発話を認識し、それに応答するシステムのことだ。AIアシスタントはスマートスピーカーやスマートフォンにも搭載され、家電など電子機器の操作を音声処理で行なえるほど、性能が高い。一方チャットボットは、入力された文章を認識し、会話や応答を行なうシステムだ。カスタマーサポートの代わりとして活用されるなど、こちらも高い処理能力を発揮している。

人間の能力を超える自然言語処理AI

非常に限られた作業において、ディープラーニングは高い性能を発揮することが実証されてきた。その一方で自然言語処理はまだまだ弱いとされてきた。国立情報学研究所が開発した「東ロボくん」は東京大学に合格するために開発されたAIである。大学入試センター試験の模擬試験で偏差値57.1を獲得したが、その一方で読解力に難があることも判明した。人間同様の読解力がAIで実現するには時間がかかると判断され、東ロボくんの開発は断念されたのだ。

だがGoogleが自然言語処理AI「BERT」を開発し、人間よりも高い読解力をもつAIが実現可能になった。このように、AIは自然言語処理の分野でも短期間で能力を急上昇させられることを実証した。

人工知能のコミュニケーション能力の問題点とは?

万能なAIの登場はまだまだ先

人工知能が人間の能力を凌駕する「シンギュラリティ」が近年話題になっている。このシンギュラリティを起こすのが、「強いAI」と呼ばれる汎用型の人工知能だ。ディープラーニングなどと異なり、ある問題や作業に特化するのではなく、状況が与えられると自ら思案し行動するAIを指す。

このような強いAIが誕生するかどうかについて諸説ある。強いAIが難しい理由として挙げられるのが、身体性をAIがもたないことだ。たとえば味覚の場合、人間ならば風味を鼻で嗅ぎわけたり、視覚から得られる食べ物の「見た目」や、食べ物を口に入れたときの「歯ざわり」を活用したりするなど、味覚の判断を統合的に行なえる。このような複雑な処理を弱いAIでは再現できないどころか、強いAIでも現状で再現するのは難しいだろうというのだ。

コミュニケーションも同様で、相手についての感情や知識、相手の身振りや手ぶり、コミュニケーション時の相手の心理状態など、あらゆる情報がコミュニケーションに関係する。だが現状では、コミュニケーションに使用されるAIは問題に特化した「弱いAI」であるため、自然言語処理能力に頼るか、別の作業の個別でAIで処理させるしかない。そのため、人間同様のコミュニケーションを取るのは現状ではまだまだ難しい。

誤認識を省みないAI

加えて、弱いAIの代表格であるディープラーニング固有の問題がある。ディープラーニングはビッグデータから規則性を学習するのだが、その規則性が人間には理解できない形式をとる。そのため、ディープラーニングの処理はブラックボックス化しているといっても過言ではない。

マイクロソフトが開発したAIチャットボット「Tay」が学習により、差別発言を繰り返したことが報じられた。人間ならば自分の発言の不適切さを判断できるが、AI処理は間違った認識だと認識できない。そのため、コミュニケーションが不適切かどうかも認識できないという問題が残るのだ。

人のコミュニケーション力を高めるためにAIが使われるケースも?

画像認識や音声認識で感情を読み取る

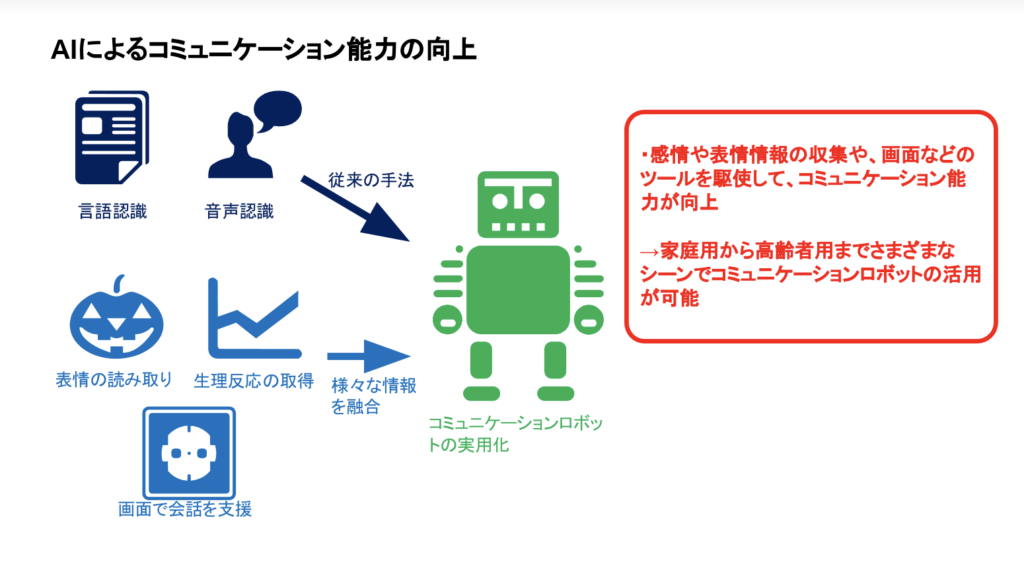

上記のようにコミュニケーション力は、適切な自然言語処理に限らない。相手の感情を理解できるか、そしてそれら理解された情報を会話やしぐさなどに取り込むことができるかなど、幅広い対応能力が求められる。とはいえ汎用的なAIは現状では存在しないので、ある作業に特化した「弱いAI」を組み合わせることで、コミュニケーション力を高めることになる。

たとえば、感情をAIで読み取る研究が行なわれている。一番単純なケースは、ロボットにセンサーを搭載することで、ユーザーの感情を読み取る手法だ。カメラを搭載することで、画像処理により、相手の表情を読み取ることができる。一見難しいように思える作業だが、マイクロソフトのクラウドサービスであるAzureは、Face APIと呼ばれる顔認識AIを提供している。これを活用すれば、相手の怒りや恐怖、喜びや悲しみ、驚きといった感情を数値化できる。

音声からの感情認識も可能だ。たとえば音声感情認識AIのEmpathは人の声から感情の解析が可能だ。人間が発する音声データを学習し、喜怒哀楽や気分の浮き沈みを判定できるという。

生体反応から感情の取得も

画像データや音声データの処理といったAIが得意とするパターン認識から感情を読み取る以外にも、人間から直接生理的な反応を計測し、AIで感情を読み取る研究も行われている。人間が発する脳波や筋電図、心電図といった生体信号から、相手の感情や思考を読み取るというのだ

コミュニケーションを円滑に行なうために、われわれは言語処理だけを行なっているのではない。相手の表情や声のトーン、汗のかき具合や心拍数など、五感を駆使してコミュニケーションが実施される。これらをAIやロボットで実現するためには、ロボットにセンサーを複数設置し、取得された情報をAIで処理し、コミュニケーションに活用することである。これにより、円滑な会話が可能になる。

コミュニケーション能力の高いAIも開発が進む

スクリーンで会話を支援するAIロボットも

AIの進化により、数々のコミュニケーションロボットが商品化されている。家庭用から高齢者向けのロボットまで、各分野に対応したものが存在するなど、細分化されている状況だ。たとえば、アメリカの名門校MITからスピンアウトしたJiboは、家庭向けのアシスタントだ。ユーザーがJiboを使用して孤独を感じないなど、高齢者を含めた孤独対策としても期待されている。

Jiboなど一部のコミュニケーションロボットには、製品にはスクリーンが搭載されるなど、コミュニケーションを補足する機能が付属している。たとえば、イスラエルのIntuition Roboticsが商品化したElliQは、液晶部分と会話するロボット部分から構成される。液晶画面にSNSにアップロードされた画像を表示させることで、視覚情報と音声情報の2方向からコミュニケーションを行なうという。

コミュニケーションロボットは高齢者向けに感じるかもしれないが、学習用のロボットも研究・開発されている。個別の児童や学生に合わせた指導を提供する「アダプティブラーニング」など、学校への就業者が少ない日本において実施するのは困難だ。そこでコミュニケーションロボットを活用し、教育のサポートを行なえば、人材不足も解消される。

感情をもつロボットも開発中

感情をもつロボットの研究・開発もすでに行われ、ソフトバンクのPepperなどがすでに商品化されている。人間の感情に相当する疑似感情をロボットにもたせることで、自然なコミュニケーションに貢献できるというのだ。センサーで人間の感情を読み取り、ロボットが疑似感情を表現する。発話によるコミュニケーションの場合、自然言語処理用のAIで十分だが、疑似感情の表現にはヒトの感情を読み取るセンサーからの情報を処理する必要があり、やはりAIが用いられるのだ。

さまざまなシーンに活用される高機能なコミュニケーション

ロボットやAIの発達により、より人間に近いコミュニケーションが可能になった。とはいえ、SFに登場するようなアンドロイドの実現はまだずっと先のことだ。現状では家庭用や高齢者用、学習用など、個別の事例に即したロボットが商品化されているのみである。だが、人手不足解消にもつながり、さらに高機能なコミュニケーションの開発が待たれる。

<参考>

- Pepper(Softbank)

https://www.softbank.jp/robot/pepper/ - 「感性ロボティクス」(『次世代センサー』Vol.27 No.1)

- 「生体信号の基礎知識」(『Interface』2017年1月号)

- 「音声感情解析AI「Empath」が目指すレジリエンスな社会」(『The Journal of Survey 測量』2018年10月号)

- 「コミュニケーションロボット「Xperia Hello!」の過去、現在、未来」(『ロボット』2019年3月号)

役にたったらいいね!

してください

No related posts.